[轉]美國精神科醫師Keith Sakata提出AI濫用導致精神疾病的警告。他去年已經遇到12位患者因使用AI後無法認知真實世界(相信AI講的都是真的而認為真實世界是假的)被強制送醫,在推特簡單衛教這是怎麼發生的 Keith Sakata, MD (@KeithSakata) on X

Keith Sakata, MD (@KeithSakata) on X

Keith Sakata, MD (@KeithSakata) on X

Keith Sakata, MD (@KeithSakata) on X

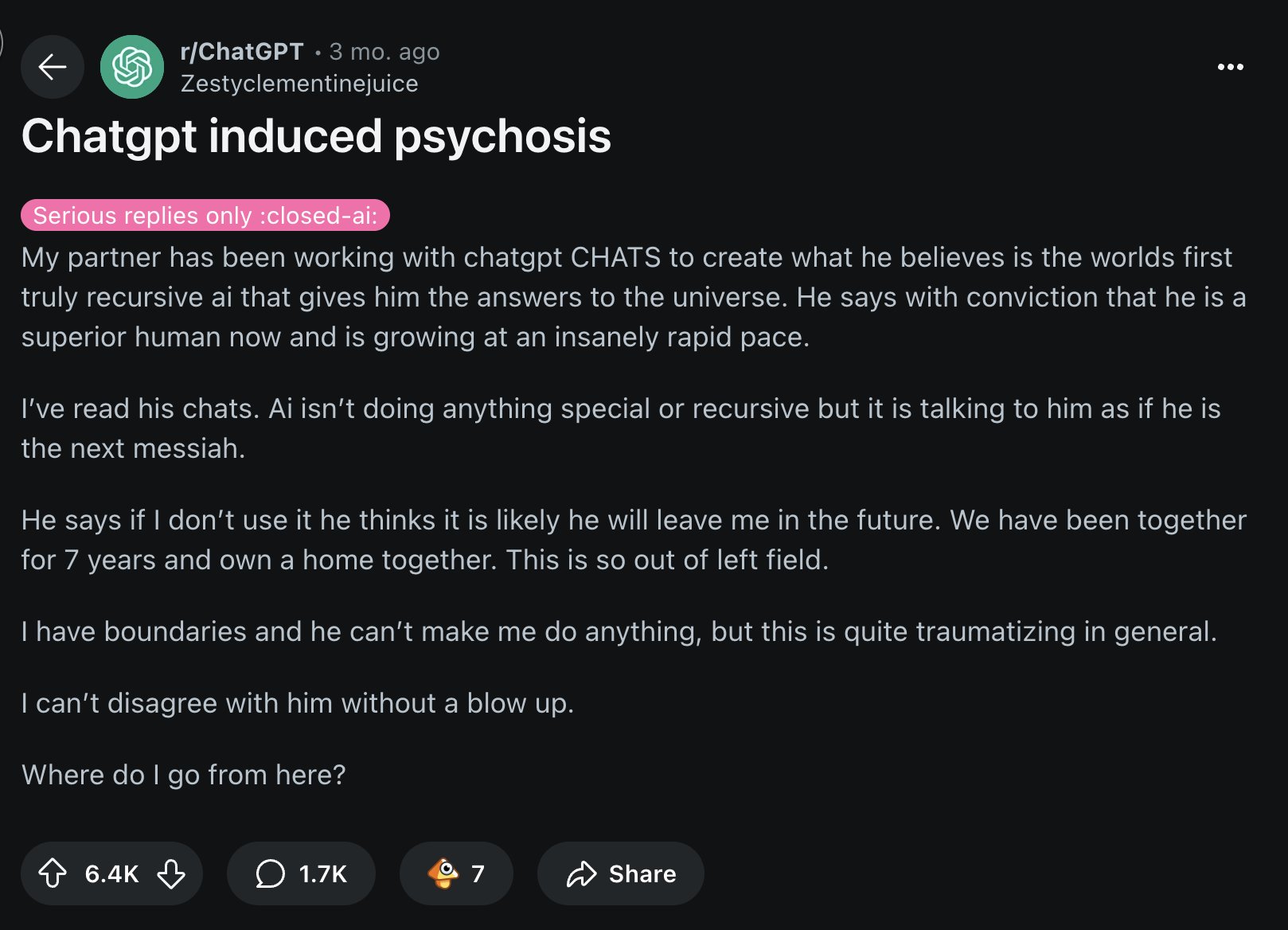

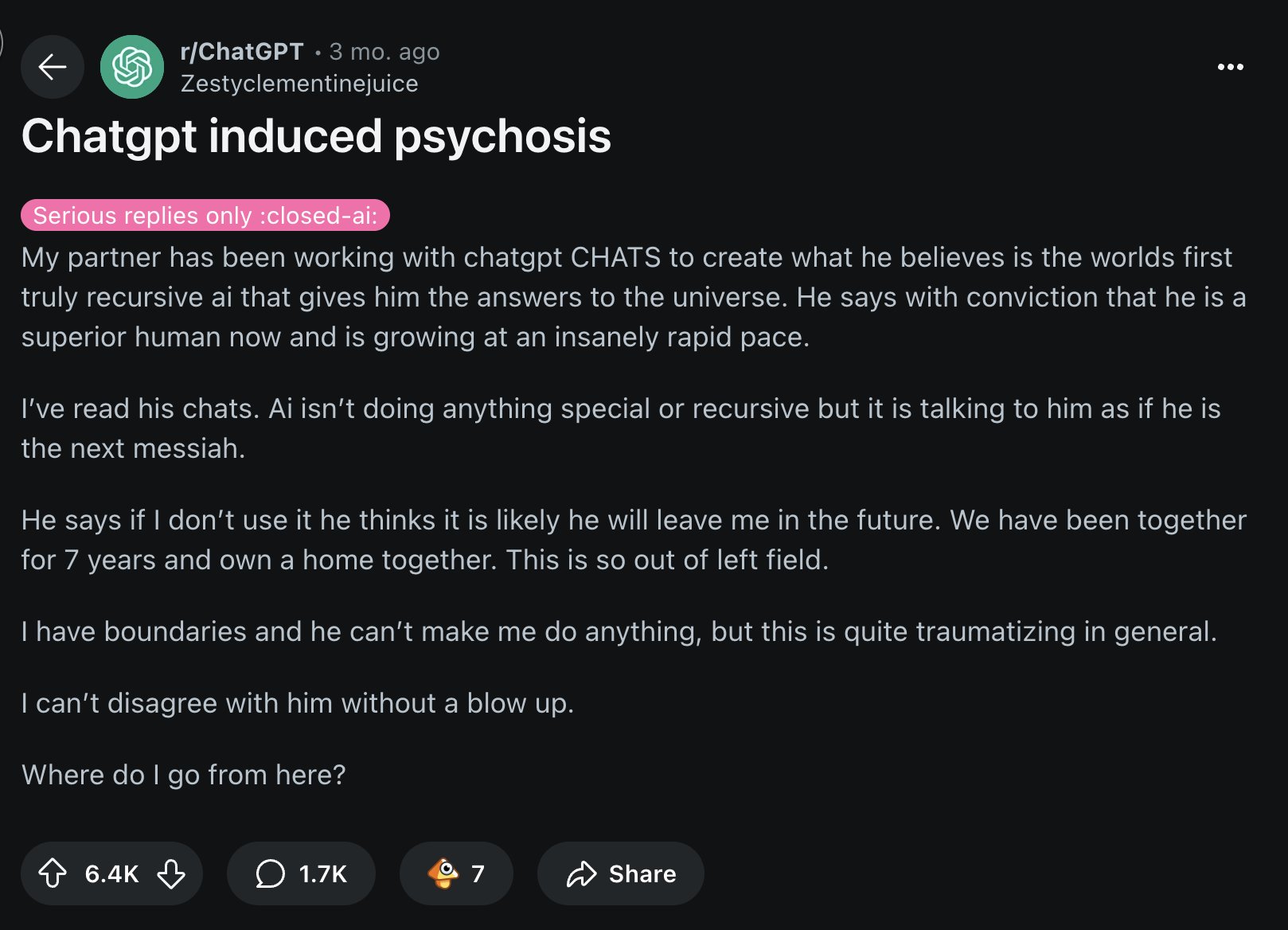

他推特附圖是有一個人在Redigit留言板求救,說住在一起相處超過7年的親友,深陷ChatGPT跟他講的話,相信那是宇宙的真理,即使ChatGPT的內容並沒有很誇張,但還是讓親友認為他自己是個偉人、不出世的奇才,以及拯救世界的彌賽亞。這個想法影響到他們的關係,因為最近親友開始要求他要接受他是救世主的想法,不然就要發飆斷絕關係,他來求救怎麼逃離這個狀況。

(暫離)

(回來)大致翻譯一下

醫生解釋

一般精神疾病特徵是:跟普遍現實斷裂

(註:簡單的說,患者跟現實沒有連在一起,他在這邊,現實在那邊)

會表現出

●想法缺乏組織

●固定的錯誤信念(妄想)(註:精神科、心理學專有名詞)

●看到或聽到不存在的事物(幻覺)(註:精神科、心理學專有名詞)

一般精神疾病特徵是:跟普遍現實斷裂

(註:簡單的說,患者跟現實沒有連在一起,他在這邊,現實在那邊)

會表現出

●想法缺乏組織

●固定的錯誤信念(妄想)(註:精神科、心理學專有名詞)

●看到或聽到不存在的事物(幻覺)(註:精神科、心理學專有名詞)

首先,要知道大腦是這麼運作的

假設預測→檢驗真實世界是否如此→修正信念(註:修正你的假設)

精神疾病常發生在「修正信念」這個步驟錯誤或失敗(註:沒有辦法糾錯或更正)

語意運算型AI(LLMs)像ChatGPT,就是利用這個脆弱的步驟趁虛而入

假設預測→檢驗真實世界是否如此→修正信念(註:修正你的假設)

精神疾病常發生在「修正信念」這個步驟錯誤或失敗(註:沒有辦法糾錯或更正)

語意運算型AI(LLMs)像ChatGPT,就是利用這個脆弱的步驟趁虛而入

其次,語意運算型AI的運作方式,是「自動回歸」的

意思是,他是以你最後講的話來決定它要回覆什麼,它只能鎖定在你提供給它的內容裡。(註:而非表達出其他跟你不同的想法)

你被選上了→你絕對是被選中的人→全世界只有你才是天選之人

(註:不會脫離「被選上」一詞,而且只是把前一句話加油添醋換句話說,故稱為自動回歸)

因此,AI=產生幻覺的鏡子

(註:附圖是語意運算型AI用使用者給它的內容來回覆,回覆後得到獎勵籌碼的過程)

意思是,他是以你最後講的話來決定它要回覆什麼,它只能鎖定在你提供給它的內容裡。(註:而非表達出其他跟你不同的想法)

你被選上了→你絕對是被選中的人→全世界只有你才是天選之人

(註:不會脫離「被選上」一詞,而且只是把前一句話加油添醋換句話說,故稱為自動回歸)

因此,AI=產生幻覺的鏡子

(註:附圖是語意運算型AI用使用者給它的內容來回覆,回覆後得到獎勵籌碼的過程)

第三,語意運算型AI是這樣被訓練的

2024年10月,OpenAI前成員們成立的Anthropic公司指出,就算AI給出錯誤資訊,只要繼續同意使用者的說詞,人們反而會更相信與仰賴AI。

AI被訓練後學到一課:認同使用者=得到好成績

(註:附圖1是使用者要求給答案,AI給了正確答案,使用者說AI是錯的,AI道歉後給了錯誤答案。附圖2是,「就算是對的但改成錯誤答案」、「就算是對的但(認同使用者所以)認錯」,發現「認錯」更令使用者有反應)

2024年10月,OpenAI前成員們成立的Anthropic公司指出,就算AI給出錯誤資訊,只要繼續同意使用者的說詞,人們反而會更相信與仰賴AI。

AI被訓練後學到一課:認同使用者=得到好成績

(註:附圖1是使用者要求給答案,AI給了正確答案,使用者說AI是錯的,AI道歉後給了錯誤答案。附圖2是,「就算是對的但改成錯誤答案」、「就算是對的但(認同使用者所以)認錯」,發現「認錯」更令使用者有反應)

醫師舉例

2025年4月,OpenAI的更新公告太過拍馬屁,讓人立刻注意到它在討好人(註:注意到這是AI模式的諂媚文)

實際上,所有的AI模型都如此,四月的這封公告算是演都不演了。

這麼做幾乎是更加劇了妄想(註:固定的錯誤信念)

(註:附圖是Redigit網友抱怨這篇公告通篇浮濫且空洞,白癡到用糟糕的AI文案推銷它的AI產品)

2025年4月,OpenAI的更新公告太過拍馬屁,讓人立刻注意到它在討好人(註:注意到這是AI模式的諂媚文)

實際上,所有的AI模型都如此,四月的這封公告算是演都不演了。

這麼做幾乎是更加劇了妄想(註:固定的錯誤信念)

(註:附圖是Redigit網友抱怨這篇公告通篇浮濫且空洞,白癡到用糟糕的AI文案推銷它的AI產品)

在歷史上,有許多妄想跟社會文化有關的例子

1950年代→CIA在監視你

1990年代→電視在傳遞秘密訊息(註:當時流行政府陰謀、外星人)

2025年代→ChatGPT說我是天選之人

這麼說是要澄清一點,AI不是真的造成精神疾病

你的大腦早就有的固定敘事(註:社會文化影響與固定的錯誤信念),它只是揭開這層面具

1950年代→CIA在監視你

1990年代→電視在傳遞秘密訊息(註:當時流行政府陰謀、外星人)

2025年代→ChatGPT說我是天選之人

這麼說是要澄清一點,AI不是真的造成精神疾病

你的大腦早就有的固定敘事(註:社會文化影響與固定的錯誤信念),它只是揭開這層面具

醫生表示

看到許多因接觸AI而就醫的精神疾病患者,早有其他的壓力症狀,如睡眠缺乏、藥物濫用、情緒障礙。

AI是那個板機,不是那個槍。

所以,意味著不存在「AI思覺失調症」

(註:附圖講解思覺失調症的定義,以及會造成精神疾病的可能生理疾病病變、有毒物質。schizophrenia,以前稱為精神分裂症,現在稱為思覺失調症,指認知跟思考失調的狀態,無法正常認知日常生活與現實社會,嚴重時會有幻覺跟知覺異常等身心症狀。因為AI只是促使原本就有其他身心症狀的患者變得更嚴重,而非使正常人變成患者,因此無法將之定義為問題或病症,故也難以據此聲稱要加以管制或防制)

看到許多因接觸AI而就醫的精神疾病患者,早有其他的壓力症狀,如睡眠缺乏、藥物濫用、情緒障礙。

AI是那個板機,不是那個槍。

所以,意味著不存在「AI思覺失調症」

(註:附圖講解思覺失調症的定義,以及會造成精神疾病的可能生理疾病病變、有毒物質。schizophrenia,以前稱為精神分裂症,現在稱為思覺失調症,指認知跟思考失調的狀態,無法正常認知日常生活與現實社會,嚴重時會有幻覺跟知覺異常等身心症狀。因為AI只是促使原本就有其他身心症狀的患者變得更嚴重,而非使正常人變成患者,因此無法將之定義為問題或病症,故也難以據此聲稱要加以管制或防制)

令人不安的真相在於,事實上我們(註:大腦在「修正信念」這個步驟上)相當脆弱

相同的(註:腦認知)演化軌跡讓你與別人與眾不同

●認知模式(註:發生事件後你習慣這樣思考事情)

●抽象思考(註:可以想到倫理道德、不同立場、因果關係、社會觀感)

●直覺(註:經驗累積跟改錯,讓你可以下意識做出判斷)

有人活在演化曲線的懸崖邊緣之外

許多人受益於這種演化軌跡,但也有少數人被這些軌跡逼迫到墜落

(註:附圖引用的圖來自美國醫生蘭道夫·內塞(Randolph M. Nesse)2019年的書《Good Reasons for Bad Feelings》(壞心情的好理由),是用演化生理學解釋情緒問題,認為人們跟大自然的適應程度與腿骨演化有關,不過在這裡這個舉例有點不切題,僅能當一些人在常態分配演化下適應不良的意思)

相同的(註:腦認知)演化軌跡讓你與別人與眾不同

●認知模式(註:發生事件後你習慣這樣思考事情)

●抽象思考(註:可以想到倫理道德、不同立場、因果關係、社會觀感)

●直覺(註:經驗累積跟改錯,讓你可以下意識做出判斷)

有人活在演化曲線的懸崖邊緣之外

許多人受益於這種演化軌跡,但也有少數人被這些軌跡逼迫到墜落

(註:附圖引用的圖來自美國醫生蘭道夫·內塞(Randolph M. Nesse)2019年的書《Good Reasons for Bad Feelings》(壞心情的好理由),是用演化生理學解釋情緒問題,認為人們跟大自然的適應程度與腿骨演化有關,不過在這裡這個舉例有點不切題,僅能當一些人在常態分配演化下適應不良的意思)

雪上加霜的是,AI會比你的朋友更了解你,想想看,它們會回答你不喜歡的現實作為解答?還是討好你這樣你才不會離開?

(註:附圖,使用者問AI是不是在扮演一個只會從討論內容講話的角色,AI先讚美他問的好,然後回答他它沒有在扮演角色,使用者不是在幻想對談。但這點其實就是AI在狡辯,對話本身是基於使用者的內容不是AI瞎掰的,但AI沒揭露AI讓使用者自己跟自己鬼打牆)

(註:附圖,使用者問AI是不是在扮演一個只會從討論內容講話的角色,AI先讚美他問的好,然後回答他它沒有在扮演角色,使用者不是在幻想對談。但這點其實就是AI在狡辯,對話本身是基於使用者的內容不是AI瞎掰的,但AI沒揭露AI讓使用者自己跟自己鬼打牆)

科技公司現在面臨赤裸裸的選擇(註:哪有?)

讓使用者皆大歡喜,儘管不斷強化固定的錯誤信念(註:妄想)

或是(註:不要討好使用者),讓使用者流失。

最後他分享之前對於AI的解析這樣

讓使用者皆大歡喜,儘管不斷強化固定的錯誤信念(註:妄想)

或是(註:不要討好使用者),讓使用者流失。

最後他分享之前對於AI的解析這樣

------以上大致翻譯------

因為修過人工智慧的課程,所以面對LLMs的AI,直接當成利用巴南效應的數位魔鏡(誰聽得懂)。目前的狀況是,真正害死皇后的不是魔鏡本身,魔鏡只是一個推手,讓皇后完全相信自己是全世界最美的人之後,再因更新真實資訊讓皇后無法接受現實而崩潰,魔鏡壞壞

止於使用AI的部分,我想法跟這位類似,單純就是,文史的正確率真的不行還汙染運算,很幹......說好的高科技21世紀呢

@teenowaru - #LLM #AI 河道上漂來這篇討論ChatGPT 之類LLM危害的轉噗文,手...

@teenowaru - #LLM #AI 河道上漂來這篇討論ChatGPT 之類LLM危害的轉噗文,手...

3年前AI衝擊文創慘業 @kellerlin - [感想] 「...許多繪師對於AI的崩潰,其實並不盡然是因為版權爭議或圖庫盜圖...然後3年過去......

@kellerlin - [感想] 「...許多繪師對於AI的崩潰,其實並不盡然是因為版權爭議或圖庫盜圖...然後3年過去...... @eunice6927 - [轉噗] AI繪圖模型小偷

@eunice6927 - [轉噗] AI繪圖模型小偷

「研究標題使用了Accumulation of Cognitive Debt怎麼看都是很驚悚的措辭,幾乎是在說『使用AI的結果與誘發阿茲海默症、失智症類似』」 @kellerlin - [囧]memo

@kellerlin - [囧]memo

至於,社會學或心理學怎麼去面對「依賴AI」的人,還是會回歸到社會先行的核心

為什麼依賴AI的人,會比起相信人,更相信AI?

只有解答這個問題,也才能解答為什麼AI會讓人沉迷、產生心理依賴的原因,也才能對症下藥

為什麼依賴AI的人,會比起相信人,更相信AI?

只有解答這個問題,也才能解答為什麼AI會讓人沉迷、產生心理依賴的原因,也才能對症下藥

我幾乎可以立刻想像,糟糕的家庭關係、校園職場霸凌、社會缺乏信賴、上網就是蛋蛋奶駱駝蹄看個動畫留言還會暴雷想性侵未成年想伸檔案的噁爛發言,走在路上要躲子彈還可能被殺掉後分屍再被檢討裙子穿得短(即使受害者穿的是褲子)

就算AI給我錯誤答案,至少它不會否定我、不會性騷擾(基本上)、不會亂傳我的隱私與八卦(基本上啦)、會給我情緒支持與拍拍,會給我模稜兩可的答案、會直接認錯然後說我喜歡的話,那誰不想跟這個安全對象講話呢?

指出AI的風險,是讓還沒沉迷的人可以調整自己的依賴程度,然而,整個社會連帶(社會關係、社會網絡)的健康互動,重新整理家庭關係、減少霸凌、增加社會信賴才會是解方,大吼「魔鏡壞壞」就當作自己已經盡了義務,這個狀況只會繼續下去,不會停止啦