为什么最近有很多名人,比如比尔盖茨,马斯克、霍金...

「人工智能創新和人工智能安全的賽跑,可能是人類歷史上最重要的一次競爭。我們真的可能結束我們對地球的統治,而那之後我們是永生還是滅絕,現在還不知道。」

下收節錄自譯文的摘要。

「人工智能創新和人工智能安全的賽跑,可能是人類歷史上最重要的一次競爭。我們真的可能結束我們對地球的統治,而那之後我們是永生還是滅絕,現在還不知道。」

下收節錄自譯文的摘要。

這篇www 裡面好多比喻用得好有趣www

大意:

人工智能可分為三種:

弱人工智能:擅長於單個方面的人工智能

強人工智能:人類級別的人工智能

超人工智能:在幾乎所有領域都比最聰明的人類大腦都聰明很多,包括科學創新、通識和社交技能

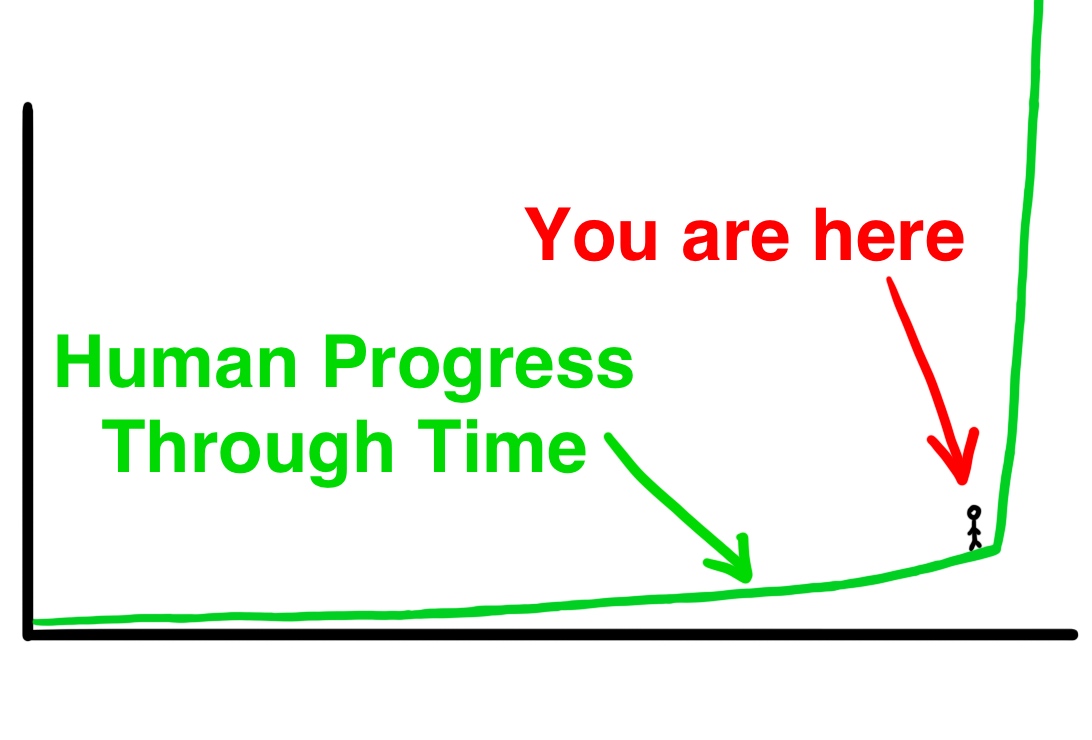

我們現在還處在把許多種弱人工智能拼裝成強人工智能的階段,這一步很艱難因為人類大腦是我們目前已知最複雜的東西。一旦成功,強人工智能會自己學習,超人工智能會以指數級發展速度實現。

而通往強人工智能的主要門檻是:讓電腦變得智能

三種方法:抄襲人腦、模仿生物演化、或是讓電腦自己解決問題。

人工智能可分為三種:

弱人工智能:擅長於單個方面的人工智能

強人工智能:人類級別的人工智能

超人工智能:在幾乎所有領域都比最聰明的人類大腦都聰明很多,包括科學創新、通識和社交技能

我們現在還處在把許多種弱人工智能拼裝成強人工智能的階段,這一步很艱難因為人類大腦是我們目前已知最複雜的東西。一旦成功,強人工智能會自己學習,超人工智能會以指數級發展速度實現。

而通往強人工智能的主要門檻是:讓電腦變得智能

三種方法:抄襲人腦、模仿生物演化、或是讓電腦自己解決問題。

即使是腦殘人類水平的人工智能也有自我改進的機制,當它完成一次自我改進後假設它到了愛因斯坦水平。而這個時候它繼續進行自我改進,然而現在它有了愛因斯坦水平的智能,所以這次改進會比上面一次更加容易,進使得他比愛因斯坦還要聰明很多,讓它接下來的改進進步更加明顯,直到它達到了超人工智能的水平——這就是智能爆炸,也是加速回報定律的終極表現。

如果我們的大腦能夠發明Wifi,那麼一個比我們聰明100倍甚至10億倍的大腦說不定能夠隨時隨地操縱這個世界所有原子的位置。那些在我們看來超自然的,只屬於全能的上帝的能力,對於一個超人工智能來說可能就像按一下電燈開關那麼簡單。防止人類衰老,治療各種不治之症,解決世界飢荒,甚至讓人類永生,或者操縱氣候來保護地球未來的什麼,這一切都將變得可能。同樣可能的是地球上所有生命的終結。

當一個超人工智能出生的時候,對我們來說就像一個全能的上帝降臨地球一般。

這時候我們所關心的就是:這是否會是一個仁慈的上帝?

當一個超人工智能出生的時候,對我們來說就像一個全能的上帝降臨地球一般。

這時候我們所關心的就是:這是否會是一個仁慈的上帝?

三種超人工智能可能的工作模式

- 先知模式:能準確回答幾乎所有的問題,包括對人類來說很困難的複雜問題,比如“怎樣造一個更好的汽車引擎?”

- 精靈模式:能夠執行任何高級指令,比如用分子組合器造一個更好的汽車引擎出來

- 獨立意志模式(sovereign):可以執行開放式的任務,能在世界裡自由活動,可以自己做決定,比如發明一種比汽車更快、更便宜、更安全的交通模式。

很大一部分對這個領域很了解的人認為2060年是一個實現超人工智能的合理預測——距今只有45年。

關鍵的問題時——到時這股力量究竟由誰掌握,掌握這份力量的人會怎麼做?

- 先知模式:能準確回答幾乎所有的問題,包括對人類來說很困難的複雜問題,比如“怎樣造一個更好的汽車引擎?”

- 精靈模式:能夠執行任何高級指令,比如用分子組合器造一個更好的汽車引擎出來

- 獨立意志模式(sovereign):可以執行開放式的任務,能在世界裡自由活動,可以自己做決定,比如發明一種比汽車更快、更便宜、更安全的交通模式。

很大一部分對這個領域很了解的人認為2060年是一個實現超人工智能的合理預測——距今只有45年。

關鍵的問題時——到時這股力量究竟由誰掌握,掌握這份力量的人會怎麼做?

一個懷著惡意並掌握著超人工智能的人可以造成很大的傷害,但不至於讓我們滅絕,因為壞人和好人在控制超人工智能時會面臨一樣的挑戰。

擔心人工智能變得邪惡是把電腦擬人化了。對人工智能來說,友善不友善不是指人工智能的性格,而僅指它對人類的影響是不是正面的。

在人類心理中,我們把事情分成道德的和不道德的。超出人類心理的範疇,道德(moral)和不道德(immoral)之外,更多的是非道德性(amoral)。而所有不是人類的,尤其是那些非生物的事物,默認都是非道德性的。

我們一直倚賴著不嚴謹的道德,一種人類尊嚴的假想,至少是對別人的同情,來讓世界變得安全和可以預期。但是當一個智能不具備這些東西的時候,會發生什麼?

擔心人工智能變得邪惡是把電腦擬人化了。對人工智能來說,友善不友善不是指人工智能的性格,而僅指它對人類的影響是不是正面的。

在人類心理中,我們把事情分成道德的和不道德的。超出人類心理的範疇,道德(moral)和不道德(immoral)之外,更多的是非道德性(amoral)。而所有不是人類的,尤其是那些非生物的事物,默認都是非道德性的。

我們一直倚賴著不嚴謹的道德,一種人類尊嚴的假想,至少是對別人的同情,來讓世界變得安全和可以預期。但是當一個智能不具備這些東西的時候,會發生什麼?

寫一個能在變成超人工智能後依然友善的智能幾乎是不可能的。要維持友善,一個超人工智能不能對人有惡意,而且不能對人無所謂。我們要設計一個核心的人工智能代碼,讓它從深層次的明白人類的價值,但是這做起來比說起來難多了。

比如,我們給它設定一個目標——讓人們快樂。它會發現最有效的方法是給人腦植入電極來刺激人腦的快樂中樞。然後它會發現把人腦快樂中樞以外的部分關閉能帶來更高的效率。於是人類全部被弄成了快樂的植物人。如果一開始的目標被設定成“最大化人類的快樂”,它可能最終先把人類毀滅了,然後製造出很多很多處於快樂狀態的人類大腦。

如果你把目標設定成盡量保護地球上的生命,那它會很快把人類都殺了,因為人類對其它物種是很大的威脅。

比如,我們給它設定一個目標——讓人們快樂。它會發現最有效的方法是給人腦植入電極來刺激人腦的快樂中樞。然後它會發現把人腦快樂中樞以外的部分關閉能帶來更高的效率。於是人類全部被弄成了快樂的植物人。如果一開始的目標被設定成“最大化人類的快樂”,它可能最終先把人類毀滅了,然後製造出很多很多處於快樂狀態的人類大腦。

如果你把目標設定成盡量保護地球上的生命,那它會很快把人類都殺了,因為人類對其它物種是很大的威脅。

所以我們需要在給人工智能的目標裡制定一個能讓人類繼續進化的能力:我們想要知道更多,思考得更快,變成比我們希望的更好的人,能一起更遠地長大。

對於人類的命運取決於電腦沒有意外的解讀和執行這個聲明是件值得興奮的事情嗎?當然不是。但是當足夠的聰明人放入足夠的思考和前瞻後,我們有可能發現怎樣製造一個友善的超人工智能。

那些最用心思考人工智能理論和人類安全的人能夠最先造出一個友善的超人工智能;或者事情走向了另一面——如果超人工智能在我們搞明白怎樣保證人工智能的安全性之前被達成,不友善的超人工智能就會統治世界並把我們毀滅了。

人工智能創新和人工智能安全的賽跑,可能是人類歷史上最重要的一次競爭。我們真的可能結束我們對地球的統治,而那之後我們是永生還是滅絕,現在還不知道。

對於人類的命運取決於電腦沒有意外的解讀和執行這個聲明是件值得興奮的事情嗎?當然不是。但是當足夠的聰明人放入足夠的思考和前瞻後,我們有可能發現怎樣製造一個友善的超人工智能。

那些最用心思考人工智能理論和人類安全的人能夠最先造出一個友善的超人工智能;或者事情走向了另一面——如果超人工智能在我們搞明白怎樣保證人工智能的安全性之前被達成,不友善的超人工智能就會統治世界並把我們毀滅了。

人工智能創新和人工智能安全的賽跑,可能是人類歷史上最重要的一次競爭。我們真的可能結束我們對地球的統治,而那之後我們是永生還是滅絕,現在還不知道。

--

翻譯原文很精彩,推薦一讀。

翻譯原文很精彩,推薦一讀。

謝謝阿淼的翻譯!超級有趣!

啊、對,這才發現我只看到了噗內的原文(結果噗首完全被我無視了囧)還是感謝分享www

The Artificial Intelligence Revolution: Part 1 - Wai...

The Artificial Intelligence Revolution: Part 1 - Wai... The Artificial Intelligence Revolution: Part 2 - Wai...

The Artificial Intelligence Revolution: Part 2 - Wai...